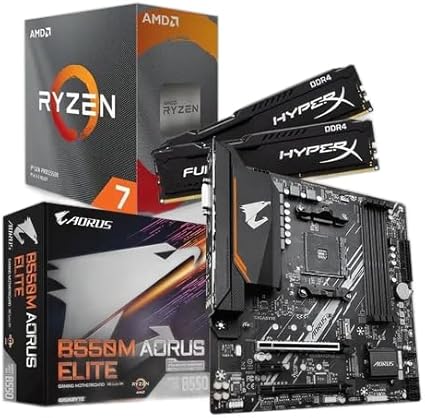

KIT UPGRADE AMD RYZEN 7 5700X, MB B550M AORUS ELITE, 16GB 3200MHZ RAM

Quem utiliza assistentes de voz, chatbots ou recursos de visão computacional lida diariamente com resultados de uma jornada iniciada há quase sete décadas. A inteligência artificial (IA), consolidada como área de pesquisa em 1956, passou por ciclos de entusiasmo, estagnação e renascimento até chegar a modelos de linguagem capazes de redigir textos, criar imagens e gerar voz com qualidade quase humana.

Da teoria filosófica ao pontapé científico em Dartmouth

Ideias sobre máquinas pensantes remontam à Antiguidade, quando filósofos gregos discutiam lógica e raciocínio. Na literatura, obras como “Frankenstein”, de Mary Shelley (1818), e a peça “R.U.R.”, de Karel Čapek (1920), popularizaram a noção de criaturas artificiais dotadas de consciência. Porém, o debate ganhou base científica no século XX com o matemático britânico Alan Turing. Entre 1936 e 1950, Turing questionou se máquinas poderiam pensar e propôs o experimento que levaria seu nome: se um computador enganar um interlocutor humano em diálogo escrito, ele demonstraria inteligência equivalente.

O campo ganhou status formal em junho de 1956, durante o Workshop de Verão de Dartmouth, nos Estados Unidos. John McCarthy, Marvin Minsky, Nathaniel Rochester e Claude Shannon reuniram pesquisadores para estudar “como tornar as máquinas capazes de comportamento inteligente”. McCarthy cunhou o termo artificial intelligence, definindo uma meta científica clara: criar sistemas que reproduzissem processos mentais humanos de forma programada.

Expectativas, invernos e ressurgimento com machine learning

Relatórios da época indicam que o otimismo inicial era elevado: alguns participantes previam, em até uma década, computadores resolvendo problemas de xadrez e tradução automática com fluência. Contudo, limitações de hardware e de conhecimento sobre cognição frearam avanços. A década de 1970 testemunhou o primeiro “inverno da IA”, período em que cortes de financiamento reduziram pesquisas, fenômeno repetido nos anos 1980.

A virada ocorreu na década seguinte, impulsionada por três fatores apontados por especialistas do Instituto de Engenheiros Eletricistas e Eletrônicos (IEEE): maior poder de processamento, queda no custo de armazenamento e abundância de dados digitais. Esses ingredientes permitiram a consolidação do machine learning, em que algoritmos aprendem padrões a partir de conjuntos massivos de informação, sem instruções linha a linha.

Nos anos 2010, o deep learning — redes neurais com diversas camadas — ganhou protagonismo. Segundo a Associação para o Avanço da Inteligência Artificial (AAAI), o método aumentou significativamente a precisão em reconhecimento de imagens, voz e texto. A partir daí, empresas como Google, Microsoft e OpenAI passaram a treinar modelos de larga escala, culminando em sistemas de geração de linguagem natural, como ChatGPT e Gemini, e em síntese de voz, como ElevenLabs.

Ferramentas atuais e aplicações cotidianas

Hoje, a IA vai além de laboratórios. Aplicativos de tradução em tempo real, recomendação de conteúdo em plataformas de streaming e sistemas de previsão de demanda em logística usam algoritmos derivados dessa evolução. De acordo com dados oficiais da consultoria IDC, o mercado global de soluções de IA deve ultrapassar US$ 500 bilhões até 2027, refletindo adoção em setores como saúde, agronegócio e finanças.

No contexto doméstico, assistentes virtuais embutidos em smartphones e alto-falantes inteligentes executam tarefas de agenda, automação residencial e controle de dispositivos. Já no ambiente corporativo, modelos de linguagem transformam rotinas de atendimento ao cliente, análise de contratos e criação de conteúdo.

Imagem: Internet

Desafios éticos e perspectivas futuras

Apesar dos avanços, a nova fase da IA levanta questões sobre privacidade, viés algorítmico e impacto no mercado de trabalho. Órgãos reguladores na União Europeia e nos Estados Unidos discutem parâmetros de transparência e responsabilização. Pesquisadores citam a necessidade de dados representativos e de auditorias independentes para evitar decisões discriminatórias.

Ao mesmo tempo, relatórios indicam que a IA pode ampliar a produtividade global. Projeções da PwC estimam contribuição de até US$ 15,7 trilhões ao PIB mundial em 2030. Especialistas afirmam que o sucesso dependerá da combinação entre capacitação profissional, infraestrutura de nuvem acessível e governança clara.

Impacto para o leitor: compreender a trajetória da IA ajuda a avaliar limites e possibilidades das ferramentas disponíveis. Saber que cada interação com um chatbot resulta de décadas de pesquisa inibe expectativas irreais e incentiva uso consciente, tanto em atividades pessoais quanto em decisões empresariais.

Curiosidade

Durante a conferência de Dartmouth, realizada em um prédio sem ar-condicionado no auge do verão, os participantes passaram as noites discutindo ideias no refeitório da faculdade, pois o ambiente era o único lugar com ventilação adequada. Relatos históricos indicam que alguns dos conceitos de redes neurais foram esboçados em guardanapos de papel, exemplo de como grandes marcos científicos podem surgir em circunstâncias improvisadas.

Se deseja aprofundar-se em outras inovações que moldam o presente e o futuro, vale conferir o conteúdo publicado em Tecnologia, onde analisamos tendências e lançamentos que influenciam o dia a dia digital.

Para mais informações e atualizações sobre tecnologia e ciência, consulte também:

Quando você efetua suas compras por meio dos links disponíveis aqui no RN Tecnologia, podemos receber uma comissão de afiliado, sem que isso acarrete nenhum custo adicional para você!