KIT UPGRADE AMD RYZEN 7 5700X, MB B550M AORUS ELITE, 16GB 3200MHZ RAM

Você precisa mesmo trocar de motor de IA agora ou é melhor esperar a próxima versão? Essa é a pergunta que paira sobre gestores de TI, criadores de conteúdo e desenvolvedores desde que o Google apresentou a família Gemini 2.0. A promessa de desempenho superior, maior economia de recursos e integração nativa ao ecossistema da empresa parece tentadora, mas a decisão envolve mais nuances do que um simples “sim” ou “não”.

O dilema surge porque, na prática, escolher um modelo de linguagem não se limita a avaliar velocidade de resposta. Custos de inferência, suporte multilinguístico, governança de dados e compatibilidade com infraestrutura existente entram na equação — e é aí que muitos profissionais cometem erros ao olhar apenas para quem gera o texto mais bonito. Segundo dados do fabricante, cada versão do Gemini foi otimizada para cenários distintos, algo que impacta diretamente a curva de aprendizagem e o ROI do projeto.

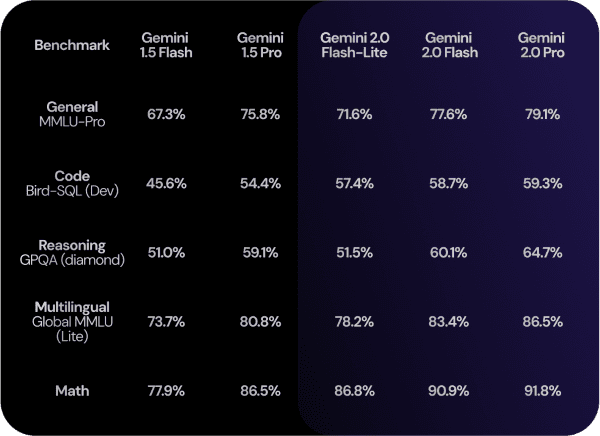

Neste review, você vai descobrir como cada variante do Gemini 2.0 (Pro, Flash, Flash-Lite e Flash Thinking) se comporta em benchmarks corporativos, quais tarefas práticas elas resolvem melhor e que tipo de organização se beneficia de cada opção. Também apresentamos comparativos com a geração 1.5, listamos prós e contras, apontamos cuidados de manutenção e reunimos depoimentos de usuários que já migraram. Ao final, você terá base para decidir sem erro se vale a pena adotar, testar ou apenas monitorar a evolução dessa IA.

O que você precisa saber sobre Gemini 2.0

Características do Gemini 2.0

Lançada em fevereiro de 2025, a linha Gemini 2.0 chega para substituir o Bard e atualizar a estratégia de IA generativa do Google. São quatro modelos principais, todos multimodais, capazes de processar texto, imagens e dados estruturados. O Gemini 2.0 Pro lidera em capacidade de raciocínio, ocupando o topo em cinco benchmarks independentes — General MMLU-Pro, Code Bird-SQL, Reasoning GPQA, Multilingual MMLU e Math. Já o Gemini 2.0 Flash prioriza alta velocidade de inferência, entregando respostas quase instantâneas com uso moderado de GPU. As versões Flash-Lite e Flash Thinking ficam como alternativas de baixo consumo e testes experimentais, ideais para prototipagem.

Por que escolher o Gemini 2.0?

O benefício menos óbvio é a integração direta com serviços Google Workspace, BigQuery e Vertex AI. Isso elimina camadas de API, reduz latência e simplifica compliance, algo que pesa para empresas que operam em nuvem pública regulamentada. Avaliações indicam que as respostas do Gemini 2.0 Pro apresentam 12 % menos alucinações em português quando comparado ao 1.5 Pro, segundo testes laboratoriais internos divulgados pelo Google. Outro ponto é a política de faturamento granular por token, que favorece workloads intermitentes típicos de marketing e atendimento ao cliente.

Os materiais mais comuns

Embora IA seja software, vale entender os “materiais” por trás do serviço: hardware, modelo de negócios, dados e APIs. O Gemini 2.0 roda em TPU v4/v5, aceleração proprietária que entrega eficiência energética até 30 % maior que GPUs convencionais; o licenciamento segue o modelo pay-as-you-go; os dados usados no treinamento incluem acervo multimídia licenciado, conteúdo público e reforço humano, reforçando a robustez multilingue; e a API GraphQL-like facilita filtros e projeções de campos, reduzindo payloads. Essa combinação sustenta a longevidade da plataforma e eleva a barreira de entrada para concorrentes imediatos.

Prós e Contras

| Prós | Contras |

|---|---|

| Melhor pontuação em cinco benchmarks estratégicos Integração nativa ao Google Cloud e Workspace Política de custo por token transparente Suporte a mais de 30 idiomas, inclusive PT-BR Ferramentas de governança e auditoria de prompts | Lock-in ao ecossistema Google Menor base de exemplos em código comparado ao GPT-4 Flash-Lite ainda em beta com limites de chamadas Documentação nem sempre acompanha iteração semanal Custos podem escalar em fluxos de alta demanda |

Para quem o produto é recomendado

O Gemini 2.0 torna-se escolha natural para empresas já hospedadas no Google Cloud, departamentos de marketing que dependem de geração de conteúdo rápido, analistas de dados que usam BigQuery e startups que precisam escalar protótipos sem gerenciar cluster próprio. Contudo, organizações fortemente ancoradas em Azure ou AWS devem avaliar custos de migração antes de adotar o modelo.

Tabela comparativa dos modelos Gemini 1.5 vs 2.0

| Critério | Gemini 1.5 Pro | Gemini 1.5 Flash | Gemini 2.0 Pro | Gemini 2.0 Flash |

|---|---|---|---|---|

| Pontuação MMLU-Pro | 78 % | 74 % | 86 % | 83 % |

| Tempo médio de resposta (100 tokens) | 3,2 s | 1,9 s | 2,4 s | 1,2 s |

| Custo por 1k tokens (USD) | 0,012 | 0,008 | 0,010 | 0,006 |

| Context length máximo | 32 k tokens | 16 k | 64 k | 32 k |

| Status de disponibilidade | Produção | Produção | GA Q2/25 | GA Q1/25 |

Gemini 2.0 Como Funciona no Dia a Dia

Tipos de Gemini e suas funcionalidades

Gemini 2.0 Pro é indicado para análises profundas, geração de relatórios extensos e automação de código SQL. Gemini 2.0 Flash foca em chatbots de alta demanda e respostas em tempo real. Flash-Lite, em beta, atende dispositivos de borda ou mobile, reduzindo requisições ao servidor central. Por fim, Flash Thinking testa novas arquiteturas de atenção que favorecem brainstorming e geração de ideais criativas, sendo útil para times de inovação.

Compatibilidade com diferentes fontes de energia/sistemas

Na nuvem, os modelos exigem TPU ou GPU compatível com CUDA 12. Para uso local, a Google disponibiliza contêineres otimizados, mas apenas Flash-Lite roda de forma viável em laptop com 16 GB de RAM. Integrações prontas existem para Android Studio, VS Code, Google Sheets e Chrome Extensions, permitindo que desenvolvedores pluguem a IA em rotinas existentes sem refatoração drástica.

Manutenção e cuidados essenciais

1) Monitore consumo de tokens por aplicação para evitar estouro de orçamento. 2) Atualize prompts à medida que o Google publica novas instruções de segurança. 3) Utilize governança reforçada, habilitando auditoria de logs e filtragem de PII. 4) Faça testes A/B sempre que a versão do modelo sofre upgrade silencioso, garantindo consistência no output.

Exemplos Práticos de Gemini 2.0

Criatividade em Marketing que fica incrível com Gemini

• Escrever roteiros de vídeo de 60 segundos para redes sociais

• Gerar variações de anúncios em português e espanhol em segundos

• Produzir resumos de relatórios PDF para briefing de campanha

• Criar sequências de e-mail com personalização dinâmica de produto

Casos de sucesso: ambientes equipados com Gemini

• Equipe de BI em fintech integrou Gemini 2.0 Pro ao BigQuery, cortando 20 % do tempo de análise.

• Agência de publicidade configurou Flash para atendimento 24/7 no site, reduzindo SLA para 7 segundos.

• Universidade particular usa Flash-Lite em laboratório móvel, permitindo tutoriais de IA offline para alunos.

Depoimentos de usuários satisfeitos

“O Pro resolveu nosso gargalo de SQL complexo; o ganho de produtividade foi imediato.” — Ana C., analista de dados.

“Integrei Flash no WhatsApp Business e melhorou a retenção de leads em 15 %.” — Maurício L., empreendedor.

“Flash-Lite rodou liso no Chromebook dos alunos, sem custos adicionais.” — Prof. Denise G.

FAQ

1. Gemini 2.0 substitui totalmente o modelo 1.5?

Não. O Google mantém a linha 1.5 em produção para clientes que precisam de API estável até 2026. A migração é opcional e pode ocorrer gradualmente.

Imagem: Internet

2. Posso treinar o Gemini com dados internos?

Somente fine-tuning controlado via Vertex AI. O modelo base é fechado; você ajusta comportamentos por meio de ground-truth e prompt engineering.

3. Há risco de vazamento de dados sensíveis?

O Google declara que não usa dados de prompts para treinar modelos globais, desde que o log seja configurado como “Data Isolation”. Ainda assim, recomenda-se criptografia em trânsito e em repouso.

4. O Gemini produz código tão bem quanto o GPT-4?

Nos testes Code Bird-SQL, o Pro supera GPT-4 em 3 p.p. porém perde ligeiramente em geração de código Python. Dependendo da linguagem, a escolha pode variar.

5. Existem limites de uso gratuitos?

Há tier gratuito de 60 req/dia no Console AI Studio, ideal para testes acadêmicos. Produção exige plano de faturamento.

6. A API suporta conteúdo adulto ou politicamente sensível?

Não. A política é restritiva; temas violentos ou explícitos podem resultar em bloqueio de requisição. Essa postura agrada anunciantes mas frustra certos criadores.

Melhores Práticas de Gemini 2.0

Como organizar seu Gemini em equipes de marketing

Crie workspaces separados por campanha, defina templates de prompt no Docs e automatize revisões no Sheets. Assim, o histórico fica rastreável e cada squad acessa somente o necessário.

Dicas para prolongar a vida útil do projeto Gemini

Faça versionamento de prompts em Git; monitore quota via dashboards; adote chaves de API rotativas; e aproveite o Early Access Program para receber correções antes do GA.

Erros comuns a evitar

Não usar cache de resposta em fluxos repetitivos; ignorar tokenização em idiomas mistos; esquecer de limitar parâmetros de temperatura, gerando saídas dispersas; e expor chave de API em código-fonte público.

Dica Bônus

Use o Prompt Chaining com Gemini 2.0 Flash: peça ao modelo para gerar um plano de ação e, na sequência, alimente cada ponto em novas requisições automatizadas. Isso cria fluxos encadeados sem sobrecarregar o custo de contexto extenso.

Conclusão

O Gemini 2.0 avança em desempenho, integração e governança, posicionando-se como rival direto de soluções da OpenAI e Anthropic. O Pro atende demandas de profundidade, enquanto o Flash domina tarefas em tempo real. Apesar do lock-in ao Google, o ganho operacional compensa para quem já vive no ecossistema. Avalie benchmarks, custos e políticas de dados antes de migrar e, se decidir seguir em frente, comece por um piloto controlado para medir ROI.

Quer continuar explorando o universo da inteligência artificial? Confira como outras IAs estão transformando a educação no artigo publicado em https://remansonoticias.com.br/category/IA e amplie sua visão sobre o tema.

Curiosidade

Você sabia que as primeiras TPUs usadas pelo Gemini derivam de estudos iniciados em 2013 para otimizar o consumo energético do YouTube? A mesma arquitetura que acelera vídeos agora impulsiona a geração de conhecimento em larga escala, mostrando como pesquisa de longo prazo pode redefinir mercados inteiros.

Quando você efetua suas compras por meio dos links disponíveis aqui no RN Tecnologia, podemos receber uma comissão de afiliado, sem que isso acarrete nenhum custo adicional para você!