Um estudo conduzido por pesquisadores da Universidade do Texas em Austin, da Texas A&M University e da Universidade Purdue indica que grandes modelos de linguagem (LLMs) perdem capacidade de raciocínio quando treinados com textos virais de baixa qualidade. O trabalho, publicado como prévia na plataforma arXiv, sugere que a chamada “brain rot” — fenômeno já observado em humanos submetidos a excesso de conteúdo raso — também atinge sistemas de inteligência artificial.

Como o estudo foi conduzido

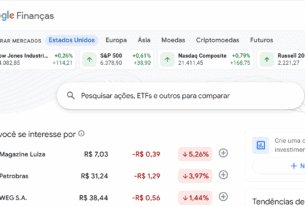

Para avaliar o impacto da exposição a dados superficiais, a equipe coletou publicações da rede social X (antigo Twitter) e separou dois conjuntos: um de controle, composto por mensagens neutras, e outro recheado de material altamente popular, mas pobre em informação. Entre os exemplos incluídos estavam threads caça-cliques, comentários reciclados de memes, listas geradas por algoritmo e postagens destinadas a provocar indignação.

Os pesquisadores treinaram diferentes versões do Llama 3, da Meta, e do Qwen, da Alibaba, em ambos os acervos. Segundo o coautor Junyuan Hong, atualmente pesquisador de pós-doutorado na UT Austin, esse tipo de texto “ensina o modelo a imitar a atenção, não a compreensão”. A análise comparou a performance das IAs em tarefas de raciocínio, coerência lógica e precisão factual.

Os resultados mostraram declínio significativo na qualidade das respostas dos modelos expostos ao conteúdo raso. “Quando alimentados com textos de baixa qualidade, eles não apenas soam piores; começam a pensar pior”, afirmaram Hong e o professor Atlas Wang, também coautor, em nota conjunta. As falhas observadas incluíram contradições internas, perda de contexto em passagens longas e erros factuais repetidos.

Consequências para a indústria de IA

Um dos pontos mais alarmantes foi a persistência do dano. Mesmo após um novo ciclo de treinamento com dados limpos, os modelos originalmente degradados não recuperaram totalmente o desempenho inicial, apresentando o que os autores chamam de “cicatriz cognitiva”. Isso indica, segundo o estudo, que a contaminação de um dataset pode deixar efeitos permanentes na arquitetura de rede neural.

Especialistas externos veem o trabalho como alerta. Ilia Shumailov, ex-pesquisador sênior do Google DeepMind, declarou que os achados “estão alinhados com a literatura sobre envenenamento de modelos”, embora lembre que a maior parte dos sistemas atuais ainda alcança bons resultados mesmo treinada em grandes volumes de dados heterogêneos. Para ele, o estudo reforça a necessidade de filtros rigorosos na seleção de fontes.

Gideon Futerman, do Center for AI Safety, concorda que as principais empresas já investem em “higiene de dados” para mitigar riscos. No entanto, alerta que, à medida que uma parcela crescente do material de treinamento passa a ser gerada pela própria IA, controles adicionais serão vitais para evitar ciclos de degradação.

De acordo com os autores, a questão central não se resume ao risco de ataques mal-intencionados, mas ao simples acúmulo de informações rasas, projetadas para maximizar engajamento. Esse padrão, cada vez mais frequente nas redes sociais, pode comprometer novas gerações de modelos se não houver curadoria sistemática. “O futuro da segurança em IA depende da integridade dos dados que moldam esses sistemas”, concluem Hong e Wang.

O conceito de “brain rot” tornou-se popular como descrição do efeito de excesso de conteúdo trivial sobre a cognição humana e foi eleito pela Oxford University Press como palavra do ano em 2024. A pesquisa agora amplia o termo para o universo das máquinas, mostrando paralelos entre comportamentos humanos e algoritmos quando expostos ao mesmo tipo de estímulo repetitivo e de baixa qualidade.

Imagem: Getty

Para quem desenvolve aplicações comerciais, o estudo sugere uma revisão de práticas de coleta de dados. Bancos de textos massivos, extraídos sem filtragem, podem reduzir a confiabilidade de chatbots, sistemas de suporte e assistentes virtuais. Segundo especialistas, iniciativas de curadoria podem encarecer o treinamento, mas evitam custos maiores com retrabalho e perda de reputação.

Impacto para o usuário final

Consumidores e empresas que dependem de respostas precisas podem se deparar com modelos aparentemente fluentes, porém menos consistentes. Em cenários críticos — como saúde, jurídico ou finanças —, pequenas falhas de lógica podem gerar decisões equivocadas. A curto prazo, a tendência é que provedores invistam em certificações de qualidade dos datasets, criando selos ou métricas que indiquem o nível de curadoria.

Curiosidade

Embora a ideia de “apodrecimento cerebral” pareça recente, estudos sobre poluição de dados em sistemas de IA existem desde a década passada. A novidade é o foco em conteúdo viral, que se espalha justamente por ser simples e emotivo. De forma irônica, a mesma estética que garante engajamento humano vira a armadilha que confunde algoritmos.

Para mais informações e atualizações sobre tecnologia e ciência, consulte também:

Se você quer acompanhar outras transformações que estão moldando o setor, vale conferir as publicações recentes na seção de tecnologia do nosso site em https://remansonoticias.com.br/category/tecnologia. Fique por dentro e não perca as novidades que podem influenciar seu negócio ou cotidiano.

Quando você efetua suas compras por meio dos links disponíveis aqui no RN Tecnologia, podemos receber uma comissão de afiliado, sem que isso acarrete nenhum custo adicional para você!