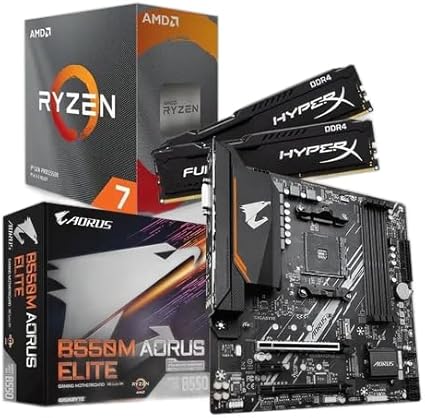

KIT UPGRADE AMD RYZEN 7 5700X, MB B550M AORUS ELITE, 16GB 3200MHZ RAM

Os Modelos de Linguagem de Grande Escala, conhecidos pela sigla LLM, tornaram-se a base da atual onda de inteligência artificial generativa. Treinados com conjuntos massivos de textos, esses sistemas conseguem compreender, gerar e resumir linguagem natural, abrindo caminho para aplicações que vão de chatbots avançados a ferramentas de programação assistida.

Arquitetura transformer e evolução dos modelos

LLMs utilizam a arquitetura transformer, projetada para processar sequências de palavras em paralelo e captar relações semânticas por meio de mecanismos de atenção. Segundo especialistas, essa abordagem resolveu gargalos de desempenho observados em redes neurais tradicionais e permitiu aumentar drasticamente tanto o volume de dados quanto o número de parâmetros treinados.

Relatórios indicam que, quanto mais camadas e parâmetros, maior a capacidade do modelo de entender contexto, nuance e intenção. GPT-4, da OpenAI; PaLM 2, da Google; Claude, da Anthropic; LLama, da Meta; e Mistral figuram entre os exemplos mais citados. Embora cada um apresente focos distintos — multilinguismo, segurança ou leveza operacional — todos compartilham a mesma premissa: usar grande poder computacional para aprender padrões linguísticos complexos.

Principais usos em empresas e produtos digitais

Na prática, as LLMs oferecem quatro frentes de valor imediato:

Geração de conteúdo: criação automática de textos, resumos e traduções, reduzindo etapas manuais em marketing, mídia e comunicação corporativa.

Atendimento ao cliente: chatbots alimentados por LLM respondem dúvidas com linguagem natural, aprendem com interações anteriores e mantêm o serviço disponível 24 horas, impactando positivamente custos operacionais.

Análise de dados textuais: as redes analisam feedbacks de usuários, interpretações de documentos jurídicos ou transcrições de suporte, entregando insights que antes exigiam extensa leitura humana.

Suporte a desenvolvedores: ferramentas como GitHub Copilot sugerem trechos de código, detectam erros e explicam funcionalidades, acelerando ciclos de desenvolvimento.

Como integrar uma LLM em projetos reais

Empresas podem adotar LLMs de duas formas. A mais rápida envolve consumir o modelo por API na nuvem do fornecedor; assim, toda a infraestrutura fica sob responsabilidade do provedor. Essa rota facilita provas de conceito e escalabilidade, pois o custo é rateado por chamada ou token.

Para organizações que exigem controle total de dados ou personalização avançada, existe a opção de hospedar o modelo internamente ou realizar fine-tuning com informações proprietárias. O processo demanda servidores equipados com GPUs, curadoria de dados e equipe especializada, mas aumenta o nível de segurança e aderência ao domínio de negócio.

Imagem: Internet

A chamada “engenharia de prompt” também ganhou destaque. Em vez de alterar pesos do modelo, a técnica consiste em formular perguntas de maneira estruturada para obter respostas mais precisas. É uma alternativa leve a projetos de treinamento extenso, pois não envolve novos ciclos de aprendizado.

Custos, riscos e cuidados necessários

Embora o acesso via API elimine investimentos iniciais pesados, o modelo de cobrança por uso pode se tornar significativo em operações de alto tráfego. Especialistas recomendam simular cenários de volume antes de escolher entre API e hospedagem local.

Do ponto de vista ético e regulatório, as LLMs herdam vieses presentes nos dados de treinamento e podem produzir respostas factualmente incorretas, fenômeno conhecido como “alucinação”. Para mitigar riscos, é fundamental manter revisão humana, registrar logs de chamadas e estabelecer políticas de uso alinhadas à Lei Geral de Proteção de Dados (LGPD).

Impacto direto para profissionais e mercado

Ao automatizar produção de texto, tradução e análise de sentimento, as LLMs aceleram fluxos de trabalho e liberam equipes para tarefas estratégicas. No médio prazo, isso tende a redefinir perfis de contratação, pressionar serviços de tradução tradicionais e elevar a exigência de competências em supervisão de IA.

Para o usuário final, a expectativa é de atendimentos mais rápidos, interfaces de voz aprimoradas e ferramentas que entregam documentação técnica simplificada. Negócios digitais que integrarem a tecnologia cedo poderão ganhar vantagem competitiva em eficiência e personalização.

Curiosidade

Em 2017, o artigo “Attention Is All You Need” apresentou o conceito de transformers que hoje sustenta as LLMs. O trabalho foi assinado por oito pesquisadores da Google Brain, e a metodologia de atenção descrita ocupa apenas algumas páginas. Esse estudo, focado inicialmente em tradução automática, tornou-se o ponto de partida para modelos que agora geram artigos inteiros, produzem código e até auxiliam em descobertas científicas.

Para continuar acompanhando avanços em inteligência artificial e suas aplicações práticas, veja também as matérias da seção de IA em Remanso Notícias, onde publicamos atualizações diárias sobre pesquisas, mercado e regulamentação.

Para mais informações e atualizações sobre tecnologia e ciência, consulte também:

Quando você efetua suas compras por meio dos links disponíveis aqui no RN Tecnologia, podemos receber uma comissão de afiliado, sem que isso acarrete nenhum custo adicional para você!