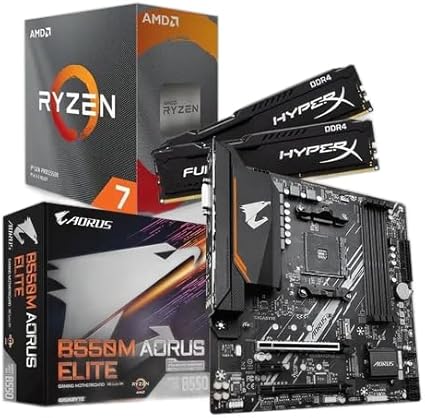

KIT UPGRADE AMD RYZEN 7 5700X, MB B550M AORUS ELITE, 16GB 3200MHZ RAM

A formulação de comandos direcionados para modelos de linguagem, conhecida como engenharia de prompt, evoluiu de simples perguntas para uma disciplina técnica capaz de orientar inteligências artificiais em tarefas complexas. Profissionais de tecnologia, equipes de produto e pesquisadores adotam métodos estruturados para extrair respostas mais precisas, reduzir erros e acelerar o desenvolvimento de soluções baseadas em IA generativa.

Definição e objetivos da prática

Segundo especialistas do setor, a engenharia de prompt consiste em elaborar instruções textuais detalhadas que informam ao modelo o papel a ser desempenhado, o formato de saída desejado e o contexto da tarefa. O objetivo central é tornar as respostas reproduzíveis, alinhadas ao propósito do projeto e livres de ambiguidades. Esse processo difere de solicitações genéricas, pois inclui parâmetros como público-alvo, tom de comunicação e critérios de avaliação dos resultados.

Relatórios indicam que empresas que investem em prompts bem estruturados alcançam reduções significativas nas chamadas “alucinações” do modelo – respostas desconexas ou factualmente incorretas. Além disso, a prática ajuda a diminuir o tempo de revisão humana, favorecendo ciclos de desenvolvimento mais curtos e econômicos.

Técnicas avançadas elevam precisão das respostas

Vários padrões de estrutura foram consolidados para otimizar interações com modelos de linguagem. Um deles é o Few-Shot Learning, no qual o prompt apresenta exemplos de entrada e saída para orientar o modelo. Outro recurso frequente é o Chain-of-Thought, que estimula o raciocínio passo a passo antes da resposta final, aumentando a transparência do processo. Há ainda o ReACT, aplicado em fluxos com múltiplas etapas, como agentes autônomos que precisam justificar cada decisão.

O ajuste iterativo também se tornou rotina. Profissionais fazem pequenos ajustes e analisam diferenças de desempenho, prática que, de acordo com dados oficiais de grandes laboratórios de IA, pode elevar em até 30% a consistência dos resultados. Essa metodologia aproxima o trabalho da engenharia de prompt de processos tradicionais de software, com versionamento, métricas e revisões contínuas.

Ferramentas especializadas estruturam o fluxo de trabalho

A popularização dos modelos de linguagem gerou um ecossistema de plataformas que gerenciam prompts em produção. PromptLayer registra versões, mede latência e exibe relatórios de desempenho. LangChain integra prompts a APIs externas, bases de dados e lógica condicional, permitindo combinar várias fontes de informação em uma mesma consulta. Já o Chainlit facilita a criação de protótipos com interface gráfica, agilizando testes com usuários finais.

Além dessas, sistemas de marketplace como PromptBase oferecem comandos prontos para tarefas específicas, monetizando a expertise dos engenheiros de prompt. Segundo dados de mercado, vagas voltadas a esse perfil já apresentam salários comparáveis aos de profissionais de machine learning, reflexo da importância estratégica da função.

Quando vale adotar prompt tuning

Apesar de relacionados, engenharia de prompt e prompt tuning atendem necessidades distintas. A primeira utiliza texto puro para orientar o modelo, enquanto a segunda ajusta vetores latentes a partir de pequeno conjunto de dados rotulados. Especialistas apontam que o tuning é indicado para problemas recorrentes e de larga escala, como atendimento automatizado com métricas rigidamente definidas. Para protótipos e experimentação rápida, a engenharia manual segue mais ágil e econômica.

Imagem: Internet

Impactos para empresas e profissionais

À medida que soluções de IA ganham espaço em setores como atendimento, geração de conteúdo e análise de dados, a qualidade do prompt passa a influenciar diretamente a experiência do usuário final. Negócios que adotam boas práticas conseguem respostas mais relevantes, menor retrabalho e maior satisfação do cliente. Para profissionais, dominar o tema amplia oportunidades em áreas de produto, dados e inovação, onde a comunicação eficaz com modelos de linguagem se torna habilidade essencial.

Na rotina do usuário comum, melhorias nos prompts significam assistentes virtuais mais úteis, e-mails automáticos com tom correto e sistemas de busca interna que retornam informações precisas. No mercado, projetos baseados em IA tendem a chegar ao estágio comercial com menor custo e maior confiabilidade, reforçando a adoção corporativa.

Curiosidade

Você sabia que o primeiro prompt documentado para um modelo de linguagem moderno pedia apenas “complete esta frase”? De lá para cá, as instruções evoluíram tanto que alguns projetos empregam mais de 1.000 tokens de contexto, com especificações de formato, exemplos e restrições de estilo. Esse avanço ilustra como a engenharia de prompt se transformou de simples comando em peça central das soluções de IA generativa.

Para ampliar sua compreensão sobre inteligência artificial, vale conferir a cobertura completa na seção dedicada a IA do nosso portal. Acompanhe as novidades e aprofunde-se em temas como modelos de linguagem, ética e automação.

Para mais informações e atualizações sobre tecnologia e ciência, consulte também:

Se você deseja acompanhar outros conteúdos sobre inteligência artificial e suas aplicações práticas, visite nossa página dedicada em remansonoticias.com.br/category/ia e continue explorando como a tecnologia pode transformar processos e carreiras.

Quando você efetua suas compras por meio dos links disponíveis aqui no RN Tecnologia, podemos receber uma comissão de afiliado, sem que isso acarrete nenhum custo adicional para você!