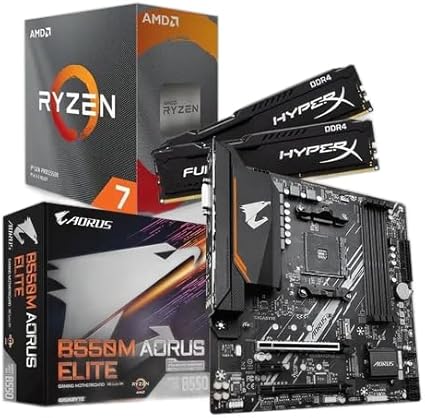

KIT UPGRADE AMD RYZEN 7 5700X, MB B550M AORUS ELITE, 16GB 3200MHZ RAM

Alexis Ohanian, um dos fundadores do Reddit, afirmou que a maior parte da internet já não é comandada por pessoas, mas por sistemas automatizados. A declaração foi feita durante participação no podcast Technologys Daily Show, onde o empresário descreveu a web atual como um ambiente “robótico”, repleto de conteúdos de baixa qualidade gerados por inteligência artificial.

O que motivou a crítica de Ohanian

No programa, Ohanian recorreu à chamada “teoria da internet morta”, segundo a qual a atividade de bots ultrapassa a interação humana em sites, redes sociais e mecanismos de busca. Para ele, as plataformas dependem cada vez mais de textos, imagens e vídeos produzidos por algoritmos, o que compromete a autenticidade das conversas on-line.

O fundador recordou que deixou o conselho do Reddit em 2020 e, desde então, observa um movimento das grandes empresas para restringir o uso de dados por modelos de IA. Segundo ele, mesmo com esses esforços, a proliferação de contas falsas e de conteúdo sintético avança em ritmo acelerado.

Ohanian destacou que podcasts ao vivo, transmissões em vídeo e comunidades menores ainda conseguem “provar que a internet está viva”, mas representam exceções em meio a um cenário amplamente automatizado.

Números confirmam o avanço dos robôs

Estudos recentes reforçam a percepção do executivo. O relatório Advanced Persistent Bots Report 2025 analisou 207 bilhões de transações web e de API realizadas em 2024 e concluiu que 50,04 % do tráfego global é gerado por robôs. Dentro desse universo, 4,8 % corresponde a bots maliciosos, usados para coletar dados, fraudar engajamento ou manipular algoritmos.

Outro levantamento, divulgado pela AWS em setembro do ano passado, aponta que 57 % de todo o conteúdo disponível on-line já é criado por sistemas de inteligência artificial. Para a Agência de Aplicação da Lei da União Europeia, a fatia de informações sintéticas pode chegar a 90 % até o fim de 2026.

O tema também foi mencionado por Sam Altman, CEO da OpenAI, que declarou recentemente que uma quantidade expressiva de contas no X (antigo Twitter) é operada por modelos de linguagem de grande porte. A afirmação corrobora a tendência verificada por pesquisadores e analistas de mercado.

Impacto para usuários e plataformas

Segundo especialistas em segurança digital, o crescimento de bots e de conteúdos fabricados por IA amplia os riscos de desinformação, fraudes financeiras e violações de privacidade. Ferramentas que imitavam comportamentos humanos para inflar curtidas ou comentários agora são capazes de produzir textos convincentes, dificultando a identificação de informações falsas.

Empresas de mídia social, por sua vez, enfrentam dilemas comerciais. De acordo com dados oficiais, mecanismos de verificação de identidade e de detecção de comportamento anômalo encarecem a operação, mas se tornaram essenciais para preservar a confiança dos usuários e atender a exigências regulatórias.

Ohanian defende que a próxima geração de redes sociais seja “comprovadamente humana”, baseada em sistemas de autenticação robustos e em formatos de interação que priorizem transmissões ao vivo e eventos em tempo real. Na visão dele, aplicativos como Signal e Discord são bons exemplos de conexões mais diretas, porém ainda não oferecem garantias contra o uso extensivo de IA em mensagens privadas.

Imagem: reprodução

Mercado em busca de soluções

Empresas especializadas em cibersegurança investem no desenvolvimento de algoritmos para diferenciar tráfego legítimo de robôs. Relatórios indicam que ferramentas de análise comportamental, aliadas a checagem biométrica, exibem taxas de acerto superiores a 90 % em ambientes controlados. No entanto, especialistas alertam que a eficácia desses métodos depende de atualizações constantes, já que os bots evoluem rapidamente.

Organismos governamentais também discutem novas regras para rotular conteúdo sintético. Propostas incluem a exigência de marca-d’água em textos, imagens e vídeos produzidos por IA, permitindo que plataformas façam a triagem automática antes da publicação.

O que isso muda para o usuário

Para o internauta comum, a principal consequência é a necessidade de redobrar a cautela ao consumir informações on-line. Especialistas recomendam verificar a origem das postagens, buscar múltiplas fontes e desconfiar de conteúdos que apelam para emoções extremas ou promessas milagrosas. A longo prazo, caso a curva de automação se mantenha, a experiência de navegação poderá exigir ferramentas adicionais de verificação, integradas diretamente aos navegadores e aplicativos.

Curiosidade

A expressão “internet morta” ganhou popularidade em fóruns em 2018, mas relatos sobre o domínio de robôs na web existem desde o final dos anos 1990, quando mecanismos de busca precisavam filtrar “spambots” em páginas de discussão. Hoje, o desafio não é apenas bloquear mensagens repetitivas, e sim distinguir produções completas, geradas em segundos por IA, de conteúdos feitos por pessoas.

Para acompanhar outras novidades sobre o universo digital, visite a seção de tecnologia do portal:

https://remansonoticias.com.br/category/tecnologia

Se você quer continuar por dentro das principais mudanças que afetam a internet e o mercado de tecnologia, mantenha-se atento às atualizações diárias aqui no site e compartilhe este artigo com amigos que se preocupam com a qualidade das informações on-line.

Para mais informações e atualizações sobre tecnologia e ciência, consulte também:

Quando você efetua suas compras por meio dos links disponíveis aqui no RN Tecnologia, podemos receber uma comissão de afiliado, sem que isso acarrete nenhum custo adicional para você!