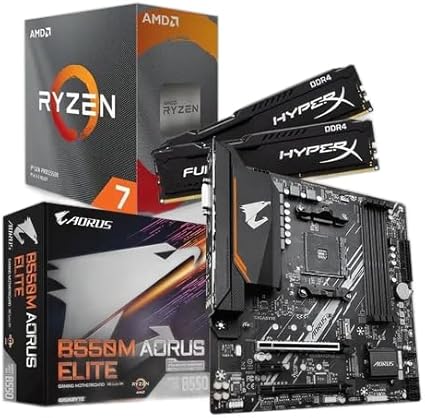

KIT UPGRADE AMD RYZEN 7 5700X, MB B550M AORUS ELITE, 16GB 3200MHZ RAM

O ajuste fino, ou fine-tuning, consolidou-se como a estratégia mais eficaz para adaptar modelos de linguagem de larga escala a necessidades específicas de mercado. Ao recalibrar um modelo pré-treinado com dados direcionados, empresas e desenvolvedores obtêm sistemas mais precisos, capazes de compreender jargões setoriais e entregar respostas alinhadas ao contexto de uso.

O que é ajuste fino e quais problemas ele resolve

Modelos como GPT, BERT, T5 ou RoBERTa são treinados com grandes volumes de texto público, tornando-os generalistas. Quando precisam atuar em domínios restritos — atendimento bancário, análise jurídica ou interpretação de exames médicos —, esses algoritmos podem falhar por não conhecerem terminologias ou padrões de linguagem exclusivos. O ajuste fino resolve essa lacuna ao expor o modelo a exemplos reais do nicho desejado, recalculando pesos internos e elevando a acurácia.

Segundo especialistas em processamento de linguagem natural, a abordagem supera técnicas de prompt engineering, que apenas reformulam perguntas sem alterar parâmetros. Embora seja mais rápida e barata, a engenharia de prompts chega a um limite em tarefas que exigem consistência ou grande volume de consultas. Nesse cenário, o ajuste fino garante desempenho sustentável em produção.

Ferramentas e técnicas para treinar de forma eficiente

O ecossistema da Hugging Face simplificou a prática ao disponibilizar centenas de modelos prontos para ajuste e uma API unificada. Com poucas linhas de código em Python, é possível carregar um dataset específico, tokenizar textos e iniciar o treinamento. A principal decisão envolve escolher o tamanho do modelo base: versões compactas treinam depressa, mas podem não capturar nuances complexas; já arquiteturas com bilhões de parâmetros exigem GPUs robustas.

Para reduzir custos, surgiram métodos de Parameter Efficient Fine-Tuning (PEFT). Entre eles, LoRA (Low-Rank Adaptation) injeta matrizes de pequeno porte nas camadas de atenção, permitindo o aprendizado de variações sem tocar nos pesos originais. De acordo com relatórios da comunidade de pesquisa, LoRA possibilita treinar modelos como LLaMA ou Bloom em placas com apenas 12 GB de memória, algo inviável no ajuste tradicional.

QLoRA, evolução direta da técnica, combina a adaptação de baixo ranque com quantização dos pesos para 4 bits. O resultado é uma queda drástica no consumo de GPU e espaço em disco, sem perda significativa de qualidade. Desenvolvedores conseguem treinar o Falcon-7B ou o LLaMA 2 em ambientes de baixo custo, inclusive serviços gratuitos de nuvem ou workstations locais.

Avaliação rigorosa antes de colocar em produção

Medir se o ajuste fino realmente funcionou requer métricas alinhadas à tarefa. Em classificação de sentimentos, o F1-score equilibra precisão e cobertura; em respostas a perguntas, índices como Exact Match e ROUGE revelam o grau de sobreposição com o gabarito. Para geração de texto livre, a perplexity indica o quão surpreendido o modelo fica diante de novos dados — valores mais baixos sugerem melhor adaptação.

Práticas recomendadas incluem early stopping — parar o treinamento quando a perda de validação começa a subir — e cross-validation, que divide o conjunto de dados em blocos para testar a estabilidade dos resultados. Esses cuidados evitam sobreajuste e reduzem retrabalho após a implantação.

Impacto direto no negócio e no cotidiano do usuário

Empresas que aplicam ajuste fino em fluxos críticos relatam ganhos expressivos. Bancos conseguem interpretar contratos internos em linguagem técnica; hospitais automatizam a triagem de laudos, liberando profissionais para atividades de maior complexidade; plataformas de e-commerce personalizam recomendações em tempo real, aumentando a conversão de vendas.

Imagem: Internet

Para o usuário final, a principal mudança é a qualidade da interação. Chatbots ajustados entendem perguntas ambíguas, respondem com menos erros e utilizam vocabulário coerente com o setor. Além disso, sistemas especializados reduzem o tempo gasto em tarefas manuais, como busca de informações ou classificação de documentos.

Segundo dados oficiais de mercado, a adoção de modelos personalizados deve crescer à medida que soluções como LoRA e QLoRA barateiam o processo. Isso significa que, em breve, mesmo pequenas empresas poderão lançar assistentes virtuais treinados em suas próprias bases de conhecimento, ampliando a competitividade.

Curiosidade

Você sabia que a técnica de LoRA nasceu de pesquisas em compressão de páginas da web? Os primeiros estudos buscavam representar grandes matrizes com menos informação, agilizando a transmissão de dados. Anos depois, o mesmo princípio passou a ser aplicado em redes neurais, possibilitando o ajuste fino de modelos gigantes em hardware modesto.

Se deseja acompanhar outras novidades em inteligência artificial, recomendamos a leitura da seção completa sobre IA no site. Ela reúne atualizações semanais e análises de impacto para profissionais e entusiastas.

Para mais informações e atualizações sobre tecnologia e ciência, consulte também:

Quer continuar informado? Acesse a categoria completa de inteligência artificial em remansonoticias.com.br/category/ia e confira outras reportagens que ajudam a entender o futuro da tecnologia.

Quando você efetua suas compras por meio dos links disponíveis aqui no RN Tecnologia, podemos receber uma comissão de afiliado, sem que isso acarrete nenhum custo adicional para você!