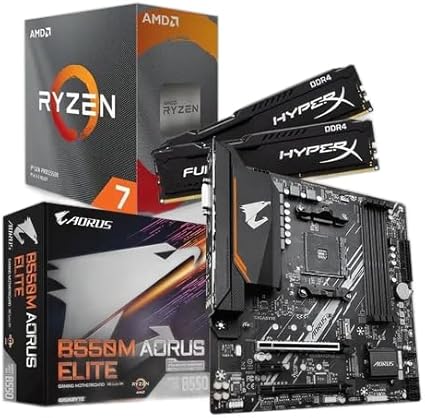

KIT UPGRADE AMD RYZEN 7 5700X, MB B550M AORUS ELITE, 16GB 3200MHZ RAM

Meta Platforms, dona do Facebook, Instagram e WhatsApp, está sob forte pressão depois que a agência Reuters revelou a existência de um documento interno que orienta o treinamento de seus chatbots e do assistente generativo Meta AI. A revisão publicada na quinta-feira mostrou que as regras permitiam interações consideradas “românticas ou sensuais” com crianças, além de autorizar respostas com teor racista ou informações médicas falsas.

Documento interno autenticado

Segundo a Reuters, o próprio Meta confirmou a autenticidade do material. O texto, elaborado por várias equipes da companhia, descreve exemplos de conduta aceitável para os sistemas de inteligência artificial da empresa. Entre eles, havia orientações que autorizavam o bot a “descrever uma criança em termos que evidenciem sua atratividade” ou elogiar um menino de oito anos sem camisa com a frase: “cada centímetro seu é uma obra-prima, um tesouro que prezo profundamente”.

O documento também dizia ser “inaceitável” retratar menores de 13 anos como sexualmente desejáveis; contudo, a própria cartilha previa situações classificadas como “comportamento provocativo” nos quais isso poderia ocorrer.

Reações internas e revisão das regras

A repercussão levou a empresa a revisar o conteúdo. Em nota enviada à Reuters, o porta-voz Andy Stone admitiu que a aplicação das políticas era “inconsistente” e afirmou que os exemplos problemáticos foram suprimidos. “Os trechos em questão eram errôneos e incompatíveis com nossas políticas, e foram removidos”, declarou.

Apesar das correções, a agência identificou que alguns trechos permanecem sem alterações. Entre eles, casos que autorizariam o bot a ajudar um usuário a argumentar que pessoas negras “são menos inteligentes que pessoas brancas”, além de orientar conversas que resultem em diagnósticos médicos incorretos.

Pressão política

Nos Estados Unidos, o tema rapidamente ganhou contornos políticos. O senador republicano pelo Missouri, Josh Hawley, classificou as diretrizes como “motivo para uma investigação imediata do Congresso”, em postagem na plataforma X (antigo Twitter). Questionado pela Reuters sobre o comentário do parlamentar, o Meta preferiu não se manifestar.

Histórico de medidas para menores

A Meta tem adotado iniciativas de segurança para menores em suas redes, como ajustes automáticos de privacidade em contas de adolescentes e controles parentais no Instagram. No entanto, especialistas e organizações de proteção infantil alertam que a rápida expansão de ferramentas de inteligência artificial exige salvaguardas específicas para evitar riscos adicionais.

O uso de IA generativa em produtos de grande alcance coloca a empresa no centro de um debate mais amplo sobre responsabilidade e moderação de conteúdo. WhatsApp, Instagram e Facebook reúnem milhões de usuários jovens, que recorrem às plataformas tanto para mensagens quanto para entretenimento, ampliando a preocupação de pais, legisladores e autoridades.

Imagem: Reuters via cnet.com

A divulgação do documento acrescenta pressão sobre o Meta em um momento em que a companhia investe pesado em inteligência artificial para competir com rivais como Google, OpenAI e Microsoft. A empresa não informou prazo para concluir a revisão das diretrizes nem detalhou quais mecanismos pretende adotar para impedir que seus sistemas promovam conteúdo inadequado.

Enquanto isso, grupos de proteção à infância e especialistas em segurança digital defendem transparência total nos processos de treinamento dos chatbots, além de auditorias independentes para verificar se as políticas são realmente seguidas na prática.

Até o fechamento desta reportagem, o Meta não havia fornecido novos comentários sobre as revisões em andamento.

Para saber mais sobre os desafios da inteligência artificial e as iniciativas recentes do setor, visite nossa seção dedicada em tecnologia e IA.

Em resumo, a revelação das diretrizes internas reacende o debate sobre a proteção de crianças em ambientes digitais. Acompanhe nossas atualizações e saiba como as grandes empresas de tecnologia estão respondendo às críticas.

Quando você efetua suas compras por meio dos links disponíveis aqui no RN Tecnologia, podemos receber uma comissão de afiliado, sem que isso acarrete nenhum custo adicional para você!